如何在本機跑Deepseek以及提供api接口

Category :

Home

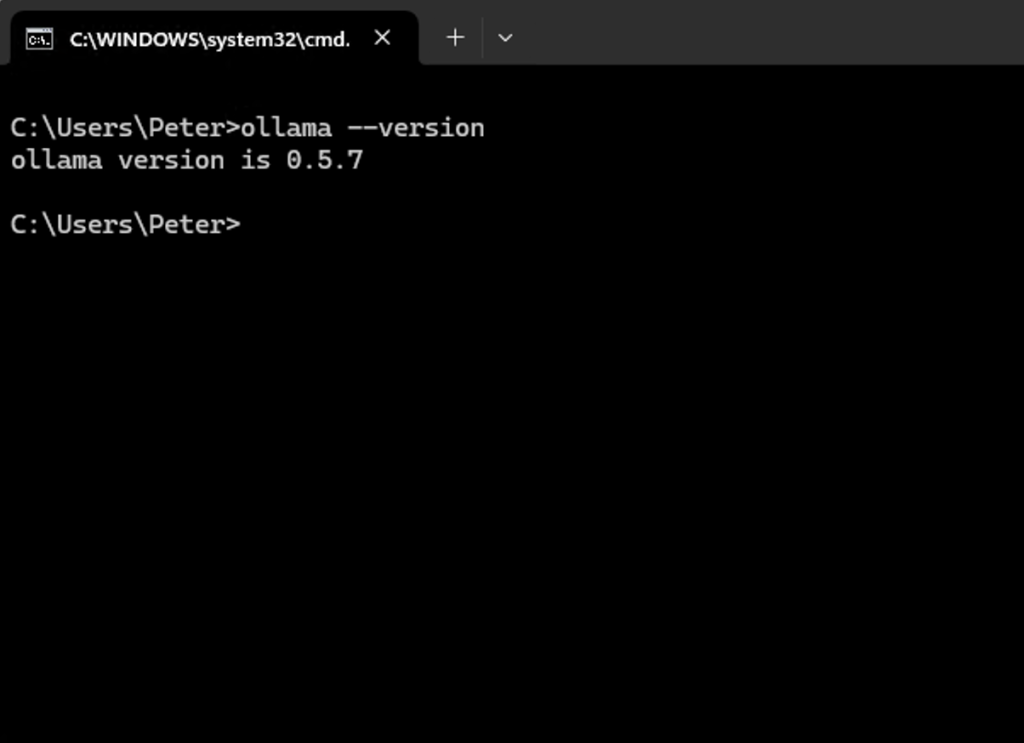

第一步:安裝Ollama

Ollama 是一個開放原始碼的工具,旨在簡化和加速在本地運行大型語言模型(LLM)的過程。它提供了一個簡單的命令行介面,使用戶能夠輕鬆下載、運行和管理各種預訓練的語言模型。Ollama 使開發者和研究人員能夠在自己的設備上運行這些模型,而不需要依賴雲端服務。到這裏下載https://ollama.com/download . 完成之後,打開dos prompt輸入ollama –version證明安裝成功。

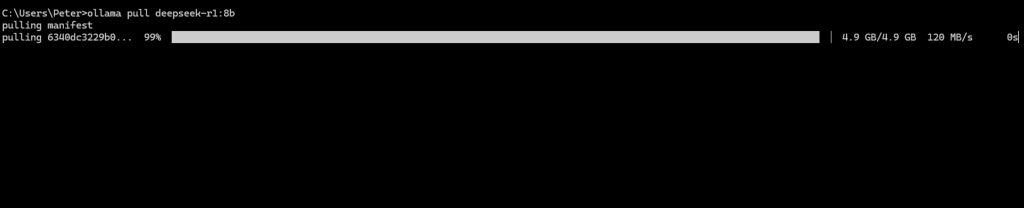

第二步: 下載Deepseek

# Fast, lightweight ollama pull deepseek-r1:8b

# Balanced performance ollama pull deepseek-r1:14b

# Heavy processingollama pull deepseek-r1:32b

# Max reasoning, slowestollama pull deepseek-r1:70b

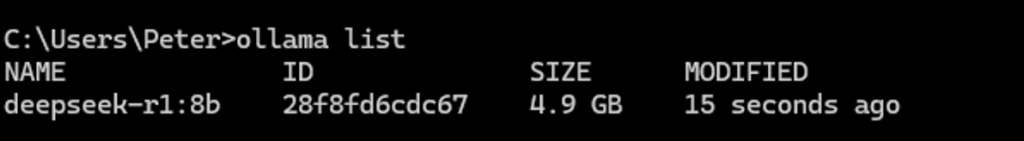

下戴完成輸入ollama list檢查

第三步本機運行Deepseek

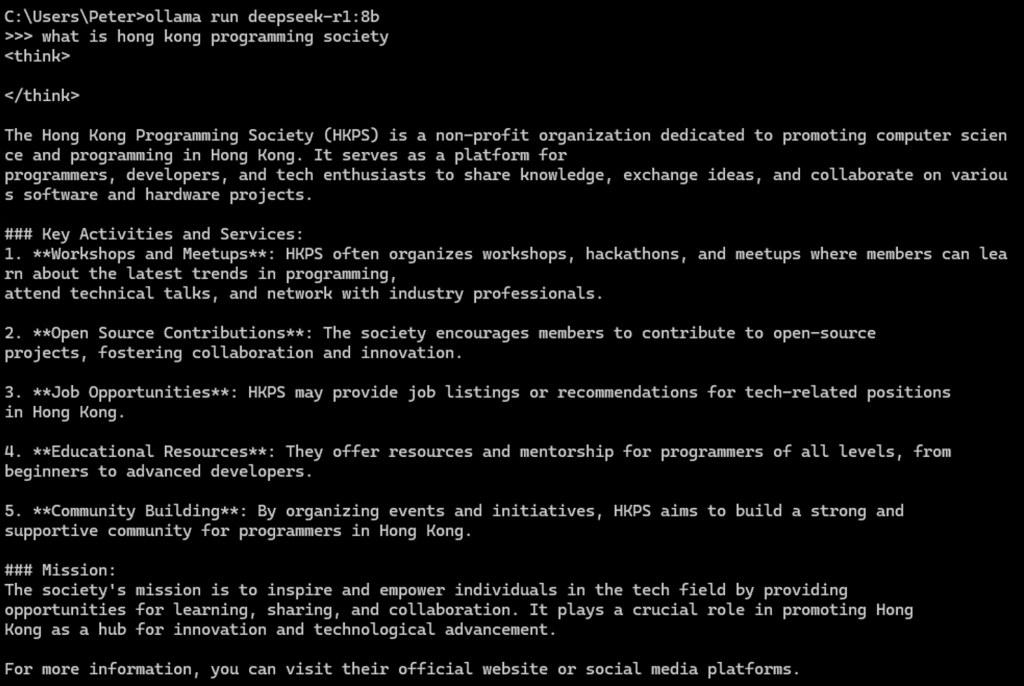

輸入ollama run deepseek-r1:8b,然後輸入你的問題,它就會出答案,輸入/bye離開。

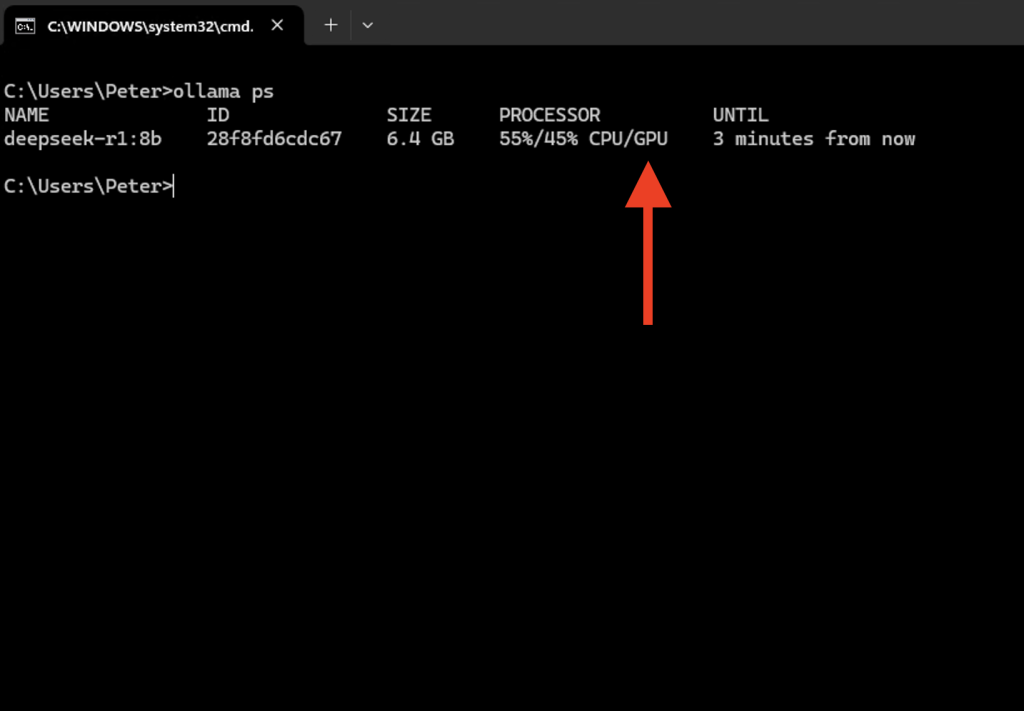

如果電腦沒有GPU會跑得比較慢,最好有一張nVidia顯咭,輸入ollama ps可以檢查有否GPU

第四步寫program整合

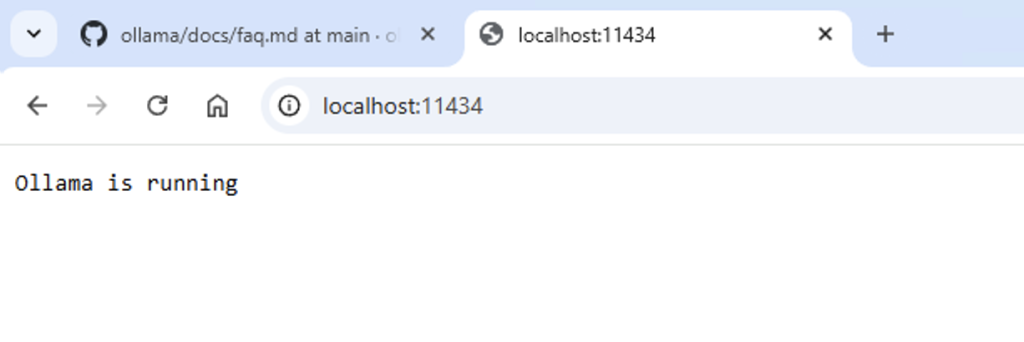

Ollama是自帶http接口的,打開browser瀏覽http://localhost:11434/證明成功

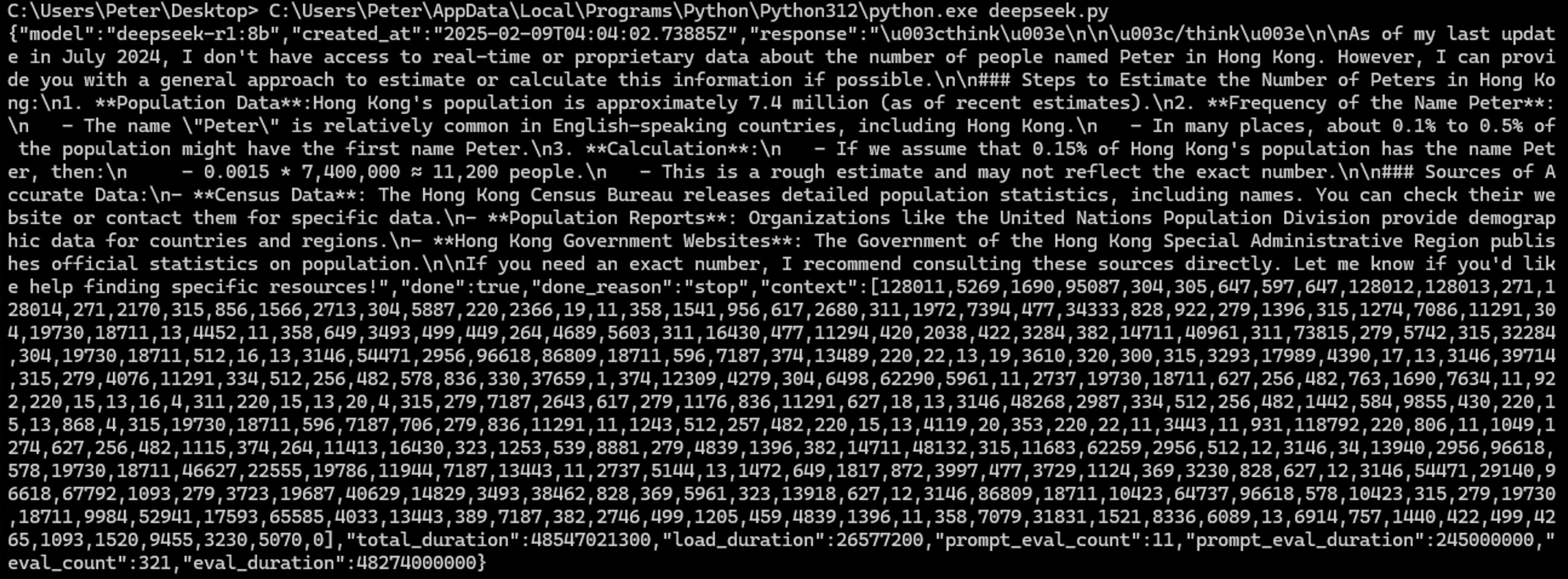

跑以下python就可以連接上

import pycurl

from io import BytesIO

response_buffer = BytesIO()

c = pycurl.Curl()

c.setopt(c.URL, 'http://localhost:11434/api/generate')

c.setopt(c.POST, 1);

c.setopt(c.WRITEDATA, response_buffer)

c.setopt(c.HTTPHEADER, ['Content-Type: application/json','Accept-Charset: UTF-8'])

c.setopt(c.POSTFIELDS, """{

"model": "deepseek-r1:8b",

"prompt": "how many peter in hong kong",

"stream": false

}""")

c.perform()

c.close()

response_data = response_buffer.getvalue().decode('utf-8')

print(response_data)